Intelligenza Artificiale e Governance, il documento di analisi del Senato

L’Intelligenza Artificiale resta la protagonista indiscussa del dibattito contemporaneo. Dato l’impatto dirompente dell’AI sulla vita pubblica e privata, le relative tecnologie appaiono oggetto di un’intensa attività normativa – sia nazionale, sia internazionale – tesa a disciplinarne principi, conseguenze ed effetti sui cittadini.

Nel solco di questo sforzo regolatorio si colloca anche il Documento di analisi n. 31, intitolato “Intelligenza artificiale: governance, responsabilità e privacy. L’impatto sul quadro normativo dei sistemi che mostrano un comportamento intelligente”, appena diffuso dall’Ufficio Valutazione Impatto (UVI) del Senato della Repubblica Italiana.

Intelligenza Artificiale: Definizioni, impatti e regolamentazione

Il testo parte dalla definizione di Intelligenza Artificiale adottata dalla Commissione europea nella Comunicazione (2018) 237, a norma della quale essa riguarda “sistemi che mostrano un comportamento intelligente, analizzando il proprio ambiente e compiendo azioni, con un certo grado di autonomia, per raggiungere specifici obiettivi”.

A seguire il documento ripercorre l’evoluzione dell’AI dal test di Turing ai Large Language Models (LMM), per arrivare ad analizzarne l’attuale stato di sviluppo e a riconoscerne l’ormai consolidata rilevanza in “tutte le attività dell’uomo, con ricadute non solo sul piano tecnologico ma anche giuridico, economico e sociale”.

Sul piano regolatorio vengono richiamati anzitutto gli atti dell’Unione Europea, come il Libro Bianco sull’intelligenza artificiale del 2020 e l’Artificial Intelligence Act (AIA), elaborato già a partire dall’anno successivo ma approvato nel 2024, che rappresenta il primo atto normativo al mondo teso a disciplinare compiutamente la materia.

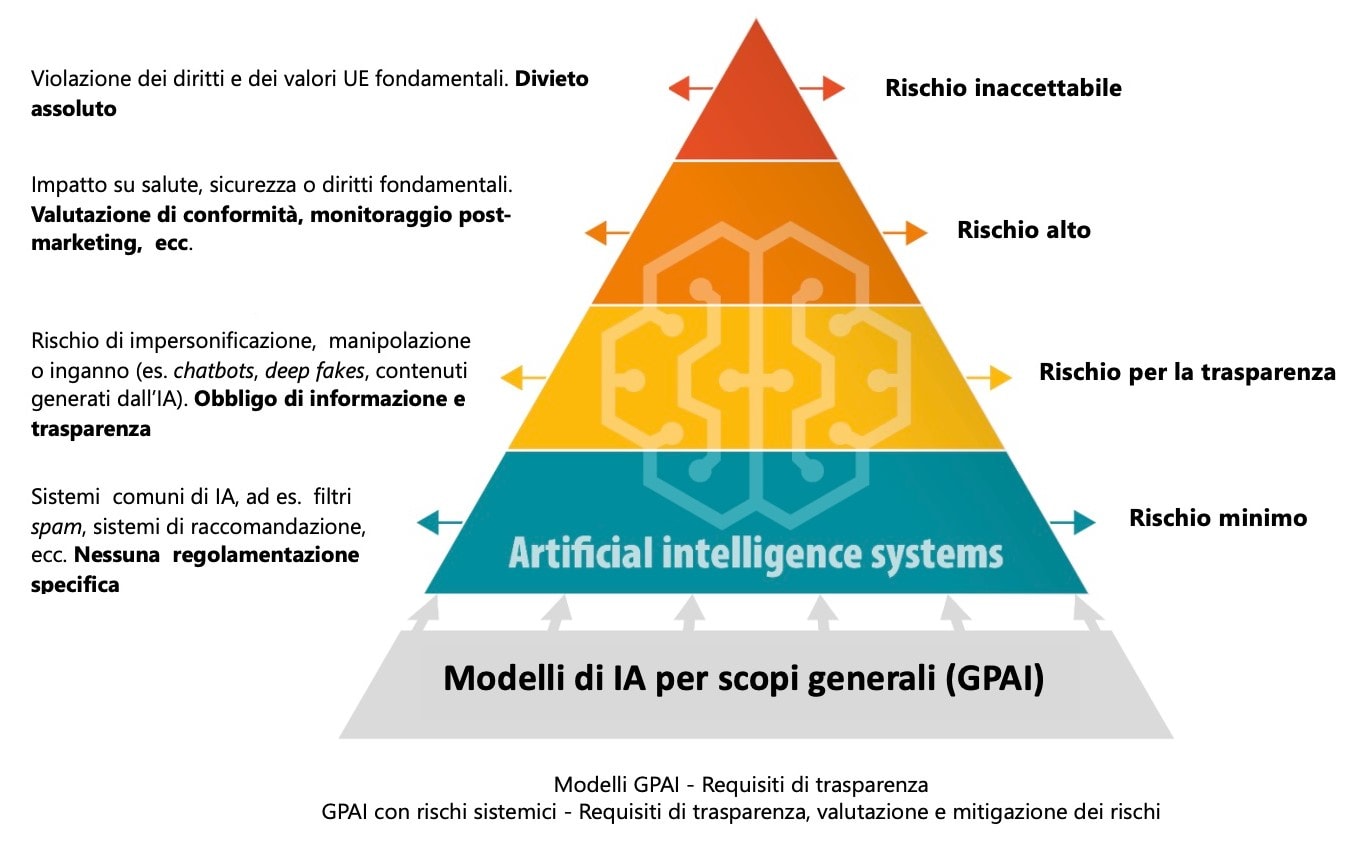

Vengono citati anche il principio di trasparenza e l’approccio risk-based previsti dal legislatore comunitario, che sceglie di graduare i livelli di rischio – minimo, alto, inaccettabile – legati all’utilizzo dell’IA, imponendo regole via via più rigorose quanto maggiore sia il livello individuato.

Si menzionano inoltre l’Executive Order on Safe, Secure, and Trustworthy Artificial Intelligence emanato dalla Casa Bianca nel 2023 e le norme adottate al riguardo da altri Paesi quali Cina, Svizzera e UK; nonché le iniziative di organizzazioni sovranazionali come l’ONU e il Consiglio d’Europa.

In particolare si ricorda come quest’ultimo abbia recentemente elaborato la Framework convention on Artificial Intelligence, Human Rights, Democracy and the Rule of Law, che sarà aperta alla firma a partire dal prossimo settembre.

Aspetti critici e responsabilità derivanti dall’uso dell’Intelligenza Artificiale

Il documento passa, poi, ad analizzare le problematiche connesse all’adozione dei sistemi di Intelligenza Artificiale.

La prima difficoltà individuata è l’assenza di una normativa specifica circa la responsabilità per i danni derivanti dai sistemi AI, che secondo un’indagine del 2020 rappresenta uno dei principali ostacoli alla sua adozione da parte delle imprese.

Da qui, l’opportunità di “integrare tale disciplina per poter fornire una maggiore tutela ai consumatori e agli operatori economici in tutto il Mercato comune europeo”.

Nel testo si ricorda che l’Italia è stata “tra i primi Stati membri a introdurre una disposizione sulla responsabilità civile per i veicoli a guida automatica, prevedendo l’obbligo di assicurazione per veicoli dotati «di tecnologie capaci di adottare e attuare comportamenti di guida senza l’intervento attivo del guidatore, in determinati ambiti stradali e condizioni esterne»”.

Fonte: Commissione europea

Vengono poi considerate le questioni relative al diritto d’autore, ricordando che da un lato “l’utilizzo di IA generativa pone delle criticità in relazione al materiale utilizzato per il cosiddetto training dei modelli stessi” e che, dall’altro, “si pone il problema della protezione del prodotto creato tramite strumenti di intelligenza artificiale generativa”.

Citando lo Study on the impact of Artificial Intelligence on the infringement and enforcement of copyright and designs pubblicato dall’European Union Intellectual Property Office (EUIPO) nel 2022, si sottolinea che “l’uso dell’IA è connesso a molteplici opportunità, drivers, limiti e preoccupazioni rispetto al rischio di violazione dei diritti di proprietà intellettuale”; concludendo che “nel disciplinare la protezione giuridica […] dovranno essere considerati fattori come il tipo di contenuto, il grado di intervento umano, la normativa applicabile (anche da un punto di vista di giurisdizione) e gli interessi che entreranno in gioco”.

Intelligenza Artificiale: Profili di Privacy e di Governance

L’ultima parte del documento di analisi si focalizza sugli aspetti legati alla protezione dei dati personali – facendo riferimento anche al complesso tema del Predictive Policing – e alla governance dell’AI.

Sotto il primo profilo si richiama ancora una volta l’AI Act, che contiene “disposizioni precise rispetto agli usi dell’IA ritenuti a rischio inaccettabile” vietando ad esempio “lo scraping non mirato delle immagini facciali, il riconoscimento delle emozioni sul luogo di lavoro e negli istituti di istruzione [e] la categorizzazione biometrica per dedurre dati sensibili, quali l’orientamento sessuale o le convinzioni religiose”.

In attesa della sua piena entrata in vigore si ricorda come abbiano trovato spazio vari interventi delle Autorità di settore, tra cui la limitazione provvisoria del trattamento dei dati degli utenti italiani imposta dal Garante Privacy italiano verso OpenAI.

Rispetto al secondo profilo, si sottolinea come esistano già diversi organismi deputati a coordinare le azioni di governance dell’Intelligenza Artificiale nel contesto comunitario.

Si tratta dell’Ufficio per l’IA e del Comitato europeo per l’IA, oltre alle nuove entità istituite dall’AIA: il “gruppo di esperti indipendenti” incaricato di fornire consulenze tecniche al suddetto Ufficio e il Forum consultivo, composto da una selezione di stakeholder rilevanti per la materia, che rappresenterà “un canale di feedback per la Commissione e il Consiglio, assicurando una rappresentazione bilanciata tra industria, start-up, PMI, società civile e ambiente accademico”.

In conclusione il documento del Senato, richiamando l’attività del legislatore nazionale – in particolare la Strategia Italiana per l’Intelligenza Artificiale 2024-2026, nella quale essa è considerata una “questione di sicurezza nazionale” – restituisce la complessità legata alla regolamentazione dell’Intelligenza Artificiale, ribadendo l’obiettivo di favorire “una trasformazione digitale inclusiva […] che sostenga la crescita economica e lo sviluppo sostenibile, in linea con i valori democratici condivisi e il rispetto dei diritti umani”.

L’Intelligenza Artificiale rappresenta una delle più grandi rivoluzioni tecnologiche della storia. Per coglierne appieno i benefici, minimizzando i rischi, è essenziale un approccio equilibrato che coniughi innovazione, etica e tutela dei diritti fondamentali. Solo attraverso una governance multilivello e un dialogo costante tra istituzioni, esperti e società civile sarà possibile plasmare un futuro in cui l’IA sia davvero al servizio dell’umanità.

AI Impact Assessment: valutare l’impatto dell’Intelligenza Artificiale

L’AI Impact Assessment (AIIA) sta emergendo come strumento cruciale per gestire i rischi e massimizzare i benefici dei sistemi di Intelligenza Artificiale. Questo processo di valutazione sistematica mira a identificare, analizzare e mitigare i potenziali impatti negativi dell’AI sulla società, l’economia e i diritti individuali.

L’Artificial Intelligence Act dell’UE introduce l’obbligo di condurre valutazioni d’impatto per i sistemi AI ad alto rischio. Questo requisito riflette la crescente consapevolezza che l’AI, pur offrendo enormi opportunità, può anche comportare rischi significativi se non adeguatamente regolamentata e monitorata.

Secondo il Joint Research Centre della Commissione Europea, l’AIIA dovrebbe essere concepito come un processo iterativo che accompagni lo sviluppo e l’implementazione dei sistemi AI lungo tutto il loro ciclo di vita.

Nel report “AI WATCH: Artificial Intelligence Impact Assessment”, il JRC sottolinea l’importanza di un approccio multidisciplinare che coinvolga esperti di diverse aree, dai tecnici agli esperti di etica e scienze sociali.

Gli elementi chiave di un AI Impact Assessment includono:

- Analisi del contesto: valutazione dell’ambiente in cui il sistema AI verrà utilizzato.

- Identificazione degli stakeholder: mappatura di tutti i soggetti potenzialmente influenzati dal sistema.

- Valutazione dei rischi: identificazione e quantificazione dei possibili impatti negativi.

- Misure di mitigazione: sviluppo di strategie per ridurre o eliminare i rischi identificati.

- Monitoraggio continuo: implementazione di meccanismi per valutare l’impatto del sistema nel tempo.

L’OCSE, nel suo documento “State of implementation of the OECD AI Principles”, evidenzia come diversi paesi stiano già adottando framework specifici per l’AIIA.

Ad esempio il Canada ha sviluppato uno strumento di valutazione dell’impatto algoritmico per le agenzie governative, mentre il Regno Unito ha introdotto delle linee guida per l’uso etico dell’AI nel settore pubblico.

In Italia, il Comitato Nazionale per la Bioetica ha sottolineato l’importanza di integrare le valutazioni d’impatto dell’AI con considerazioni etiche. Nel parere “Intelligenza Artificiale e Medicina: Aspetti Etici”, il Comitato raccomanda che l’AIIA includa una valutazione approfondita delle implicazioni etiche, soprattutto in ambiti sensibili come la sanità.

L’AI Impact Assessment si configura quindi come un elemento chiave nella governance responsabile dell’Intelligenza Artificiale. Esso rappresenta un ponte tra l’innovazione tecnologica e la tutela dei diritti individuali, contribuendo a creare ecosistemi AI che siano non solo avanzati, ma anche etici e sostenibili.

La sfida per il futuro sarà quella di standardizzare le metodologie di AIIA, garantendo al contempo la flessibilità necessaria per adattarsi ai rapidi progressi tecnologici e alle diverse esigenze settoriali. Sarà essenziale, inoltre, promuovere una cultura della valutazione d’impatto tra gli sviluppatori e gli implementatori di sistemi AI, affinché l’AIIA diventi una prassi consolidata e non un mero adempimento normativo.

In conclusione, l’AI Impact Assessment si sta affermando come uno strumento indispensabile per guidare lo sviluppo e l’adozione responsabile dell’Intelligenza Artificiale, contribuendo a plasmare un futuro in cui l’innovazione tecnologica proceda di pari passo con il benessere sociale e la tutela dei diritti fondamentali.