Atti Convegno Cyber Crime Conference 2018 – Monica A. Senor

AI and Bad Robots – Le sfide giuridiche della robotica intelligente

Il mio intervento riguarda la robotica intelligente e le sfide giuridiche che essa ci impone.

Dobbiamo partite da un dato, che ci costringe a focalizzare l’attenzione sul discrimine tra la cosiddetta weak A.I. – detta anche narrow A.I.- e la strong A.I. La prima, quella che conosciamo meglio, è in grado di riprodurre comportamenti umani e viene applicata ai meccanismi predittivi e agli strumenti di machine learning di cui tanto sentiamo parlare. Si contrappone alla intelligenza artificiale “forte” – o generale – che dovrebbe riuscire non a riprodurre un comportamento umano ma a produrre la stessa intellligenza umana. C’è un ampio dibattito sulla possibilità che si riesca effettivamente ad addivenire a questo secondo tipo di A.I.: ci sono persone (come Elon Musk) che lo ritengono assolutamente verosimile e sono anche molto preoccupate per il possibile impatto sulla società e ce ne sono altre – cito in particolare il filosofo italiano Luciano Floridi, professore di filosofia ed etica dell’informazione all’Università di Oxford – che ritengono si tratti di uno scenario molto lontano, se non irraggiungibile.

Quindi partiamo dal presupposto di dover prendere in considerazione un’intelligenza artificiale weak applicata alla robotica, quindi a un paradigma che consente alla macchina di sentire – cioè raccogliere dati dall’esterno – pensare – ovvero processarli ed elaborarli – e agire di conseguenza. Quest’ultima capacità, presuppone che la macchina sia in qualche misura capace di prendere delle decisioni autonome, basandosi sull’elaborazione degli input esterni. Quanto più la macchina è in grado di compiere decisioni autonome tanto più può diventare imprevedibile, ed è questa la vera sfida sul piano giuridico.

Un esempio: qualche tempo fa, nel corso di una sperimentazione che riguardava la taratura e la precisione del volo di un drone, era stato imposto alla macchina di avvicinarsi il più possibile a un determinato punto; se il drone si allontanava, il programma gli imponeva di riavvicinarsi. A un certo punto si è notato che, quando raggiungeva una distanza “di allerta” – programmata come circonferenza massima dell’area di azione – il drone, anziché avvicinarsi tentare di riportarsi al centro, usciva completamente dall’area, assumendo un comportamento che potenzialmente avrebbe potuto causare dei danni fisici alle persone, trattandosi di una macchina fuori controllo. Perché il drone faceva questo? Perché aveva “imparato” che al momento dell’uscita dal perimetro, veniva disattivato e riportato manualmente al punto d’origine dal programmatore: il drone riteneva che quella fosse la soluzione più rapida e sicura per avvicinarsi all’obiettivo dato. L’interpretazione più logica per la macchina era, in questo caso, illogica per l’uomo: queste sono le vere sfide del diritto, capire come prevedere, prevenire e da ultimo sanzionare eventuali azioni di questo tipo.

Frank H. Easterbrook, giudice federale e professore universitario americano, a metà degli anni Novanta elaborò la cd. legge del cavallo, un concetto che fu poi ripreso da Lawrence Lessig un articolo pubblicato sulla celebre Harvard Law Review. All’epoca il riferimento era la cyber law, quindi le prime problematiche relative al diritto dell’informatica. L’esempio, molto simpatico ed efficace, è questo: prendiamo un cavallo (che potrebbe tranquillamente essere sostituito, oggi, con un robot intelligente). Ci sono diversi casi che possono avere ad oggetto questo animale, come il fatto che possa aggredire qualcuno, avere bisogno di trattamenti veterinari specifici, partecipare a corse o competizioni che devono essere regolamentate: questo non significa che dobbiamo elaborare una “legge del cavallo”, essendo sufficiente la regolamentazione di ogni settore in cui il cavallo possa trovarsi ad agire. Questo è il dilemma del giurista: se sia cioè necessario prevedere una nuova normativa ogni qualvolta si presenti un’evoluzione tecnologica significativa, o se sia sufficiente interpretare in senso evolutivo le norme già esistenti al fine di tutelare beni ed interessi minacciati da nuove potenziali violazioni. Personalmente preferisco la seconda impostazione, che è anche quella del giudice Easterbrook: se non perdiamo di vista i principi generali, molto probabilmente riusciremo sempre ad offrire efficaci soluzioni giuridiche anche a fenomeni nuovi.

Qual è la vera novità della robotica intelligente? Che per la prima volta vengono a confondersi e sovrapporsi due aspetti che sinora erano rimasti separati, cioè il concetto di immaterialità del dato – che dal punto di vista giuridico ha a che fare con la cyber law – e la materialità della macchina, che può causare danni, anche fisici, alle persone. Se ci pensate è esattamente la sintesi dell’evoluzione della nostra società: siamo passati dal reale al virtuale e oggi ci troviamo davanti alla loro sommatoria. Questo significa anche, però, che le problematiche irrisolte di entrambi i mondi possano creare difficoltà interpretative rispetto alle questioni giuridiche sollevate dalle macchine evolute.

Rimanendo a livello di principi generali, cosa comporta l’inteligenza artificiale applicata alla robotica? Comporta l’esigenza di individuare e disciplinare l’interconnessione tra gli aspetti giuridici di security, propri della cyber law e quelli legati alla safety, propri delle macchine. Al riguardo è interessante rilevare come in italiano si parli solo di “sicurezza”, un termine unico, mentre esiste un’importante differenza concettuale tra security e safety. Informatici e ingegneri sono abituati a questa distinzione, mentre noi giuristi la affrontiamo di rado: ma la differenza è rilevante, perché la security riguarda gli attacchi esterni alla macchina – parliamo di attacchi prevalentemente informatici – mentre la safety ha a che fare con tutti gli aspetti di progettazione della macchina volti a salvaguardare l’incolumità fisica delle persone. La differenza è evidente pensando, ad esempio, alle self-driving cars: dobbiamo avere una parte di security che tuteli il sistema informatico delle auto senza pilota da eventuali attacchi esterni ma, allo stesso tempo, dobbiamo applicare tutte le disposizioni normative che riguardano la safety, ovverosia che rendono la macchina in grado di non ledere l’incolumità di soggetti terzi. A questi due concetti deve aggiungersi quella che io chiamo cyber safety: con questo intendo l’incolumità non tanto dei corpi fisici (il drone che mi cade in testa, l’incidente stradale provocato dalla self-driving car) quanto l’aspetto di sicurezza digitale legato ai diritti e alle libertà fondamentali delle persone. Questo è un aspetto esplicitamente previsto nel nuovo Regolamento europeo sui dati personali ed è il concetto che meglio sintetizza l’esigenza di tutela del corpo digitale: noi, infatti, oggi siamo un corpo fisico ma siamo anche la sommatoria di tutti i dati che immettiamo in rete – volontariamente o meno – e che, una volta elaborati, consentono alle macchine intelligenti di operare e di muoversi (l’agire del paradigma sense, think, act). Il GDPR, laddove parla di data breach, valutazione d’impatto e sicurezza del dato, fa riferimento al rischio di violazione dei diritti e delle libertà fondamentali. Si tratta del principio che il Professor Rodotà aveva teorizzato nel concetto di habeas data, trasponendo nella moderna ICT society lo storico concetto di habeas corpus (relativo all’integrità fisica) elaborato sin dai tempi della Magna Charta.

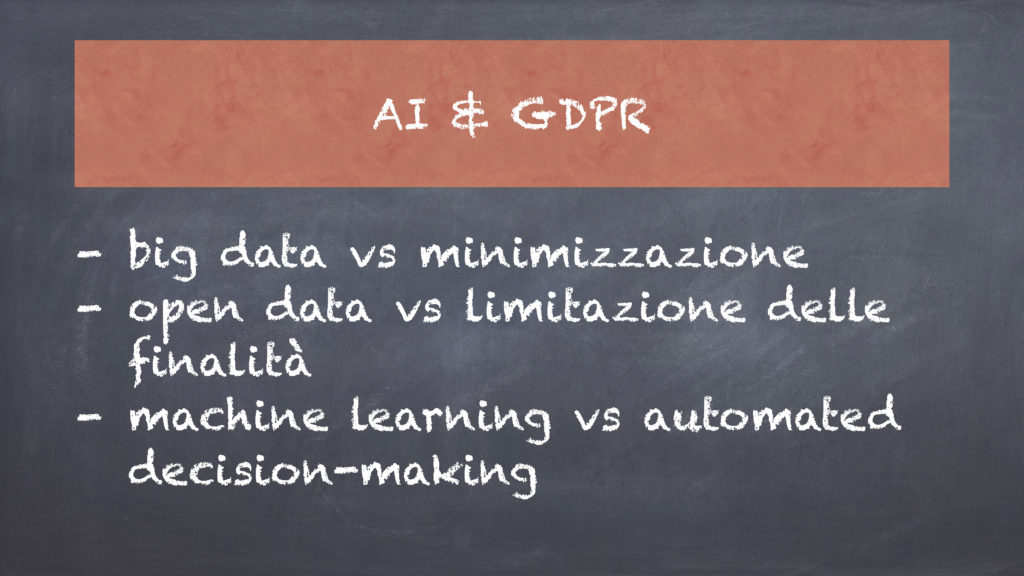

Cosa succede allora? Che ciò che risulta veramente innovativo e richiede di essere regolamentato (ma in Europa lo stiamo facendo) è il rapporto tra intelligenza artificiale e data protection: e si tratta di un rapporto-scontro, nel senso che da una parte gli algoritmi di machine learning hanno bisogno di grandi quantità di dati per generare risultati sempre più utili e precisi e, dall’altra, il principio di minimizzazione imposto dal GDPR ci dice che dobbiamo trattare soltanto i dati minimi indispensabili. Questi due concetti entrano in conflitto: da una parte la tecnologia che richiede sempre più dati, dall’altra la regolamentazione che ne limita il trattamento. La stessa cosa avviene nel rapporto tra open data e principio di limitazione delle finalità: da una parte dati aperti, a cui chiunque può accedere per elaborarli, dall’altra un principio giuridico che impone di trattare i dati solo per finalità specifiche, espresse e preventivamente dichiarate al soggetto titolare di quel dato. Ultima contrapposizione: il divieto assoluto, espresso nel GDPR, di decisioni autonome assunte dai sistemi senza alcun intervento umano. Questo tipo di decisioni, salvo eccezioni di legge, è vietato ogniqualvolta incida su diritti e aspetti rilevanti della vita degli interessati: di nuovo abbiamo da un lato la tecnologia che forza per trovare ed imporre soluzioni e decisioni sempre più automatizzate – soprattutto nella misura in cui ci accorgiamo che funzionano e che possono rendere la nostra vita più semplice – mentre dall’altro c’è una normativa che frena soluzioni preoccupata delle possibili conseguenze sui diritti fondamentali dell’uomo.

Fermi i principi generali del diritti e preso atto che la normativa sulla privacy (o più correttamente sulla data protection), rappresenta, al momento, il freno maggiore alla grande spinta tecnologica verso la robotica intelligente, sicuramente risulta necessario adottare regolamentazioni di dettaglio – spero abbiate apprezzato che non vi abbia parlato di responsabilità extracontrattuale o penale, limitandomi alla data protection dove lo scontro di cui parliamo risulta più evidente – perché può succedere sia necessario mettere dei “paletti” di tipo tecnico-legale. Due esempi: i droni, che in Italia sono oggetto di una disciplina specifica prevista dal Regolamento ENAC, mentre negli Stati Uniti, ad esempio, oltre alle regole della FAA (Federal Aviation Administration), sono stati creati veri e propri corridoi aerei dedicati alla sperimentazione e le eccezioni alla regolamentazione ordinaria previste per le self-driving cars (sempre negli Stati Uniti, sono state chieste, ad esempio, per progredire nella sperimentazione, esenzioni alla normativa federale sulla sicurezza degli autoveicoli nella parte in cui prevedeva l’intervento umano). Come vediamo, si tratta più di regolamentazioni di dettaglio che non della necessità di introdurre un’espressa normativa ad hoc: nessuna legge sui cavalli-robot, per ora!

Chiudo ricordando che le problematiche giuridiche in questo campo sono numerosissime: io, che amo molto la materia, ne sono affascinata. Se avete voglia di divertirvi e capire meglio le paranoie che ci facciamo noi giuristi, potete guardare il sito di We Robot 2018 (ove trovate anche gli anni precedenti). Io ho avuto la fortuna di partecipare all’edizione del 2016: si tratta di una conferenza annuale, itinerante tra le università statunitensi (l’ultima si è tenuta a Stanford), in cui vengono presentati e discussi articoli accademici che sollevano questioni estremamente interessanti. Tra i temi di quest’anno vi segnalo Is Tricking A Robot Hacking?, un elaborato in cui gli autori si domandano se ingannare un agente artificiale sia l’equivalente (a livello giuridico, ovviamente) di hackerarlo, con una serie di interessanti implicazioni in merito all’adversarial machine learning ed un paper titolato Remedies for Robots, che esamina le problematiche connesse al risarcimento dei danni in forza della law of remedies americana, ovverosia, in sintesi: fintanto che parliamo di compensazioni in denaro non ci sono difficoltà ad applicare le normative esistenti, ma come ci comporteremo al momento di chiedere a un giudice di inibire (o imporre) a un robot intelligente un determinato comportamento? Sono problematiche amplissime e molto stimolanti per chiunque ami il diritto.

Monica A. Senor, Avvocato penalista, fellow del Centro Nexa su Internet e Società